Update README.md

Browse files

README.md

CHANGED

|

@@ -1,290 +1,292 @@

|

|

| 1 |

-

---

|

| 2 |

-

license: apache-2.0

|

| 3 |

-

language:

|

| 4 |

-

- en

|

| 5 |

-

- zh

|

| 6 |

-

pipeline_tag:

|

| 7 |

-

library_name: diffusers

|

| 8 |

-

tags:

|

| 9 |

-

- video

|

| 10 |

-

- video-generation

|

| 11 |

-

|

| 12 |

-

|

| 13 |

-

|

| 14 |

-

|

| 15 |

-

|

| 16 |

-

|

| 17 |

-

|

| 18 |

-

|

| 19 |

-

|

| 20 |

-

|

| 21 |

-

|

| 22 |

-

|

| 23 |

-

|

| 24 |

-

|

| 25 |

-

|

| 26 |

-

|

| 27 |

-

- [

|

| 28 |

-

- [

|

| 29 |

-

- [

|

| 30 |

-

- [

|

| 31 |

-

|

| 32 |

-

|

| 33 |

-

|

| 34 |

-

|

| 35 |

-

|

| 36 |

-

|

| 37 |

-

|

|

| 38 |

-

|

| 39 |

-

|

| 40 |

-

|

| 41 |

-

|

| 42 |

-

|

| 43 |

-

|

| 44 |

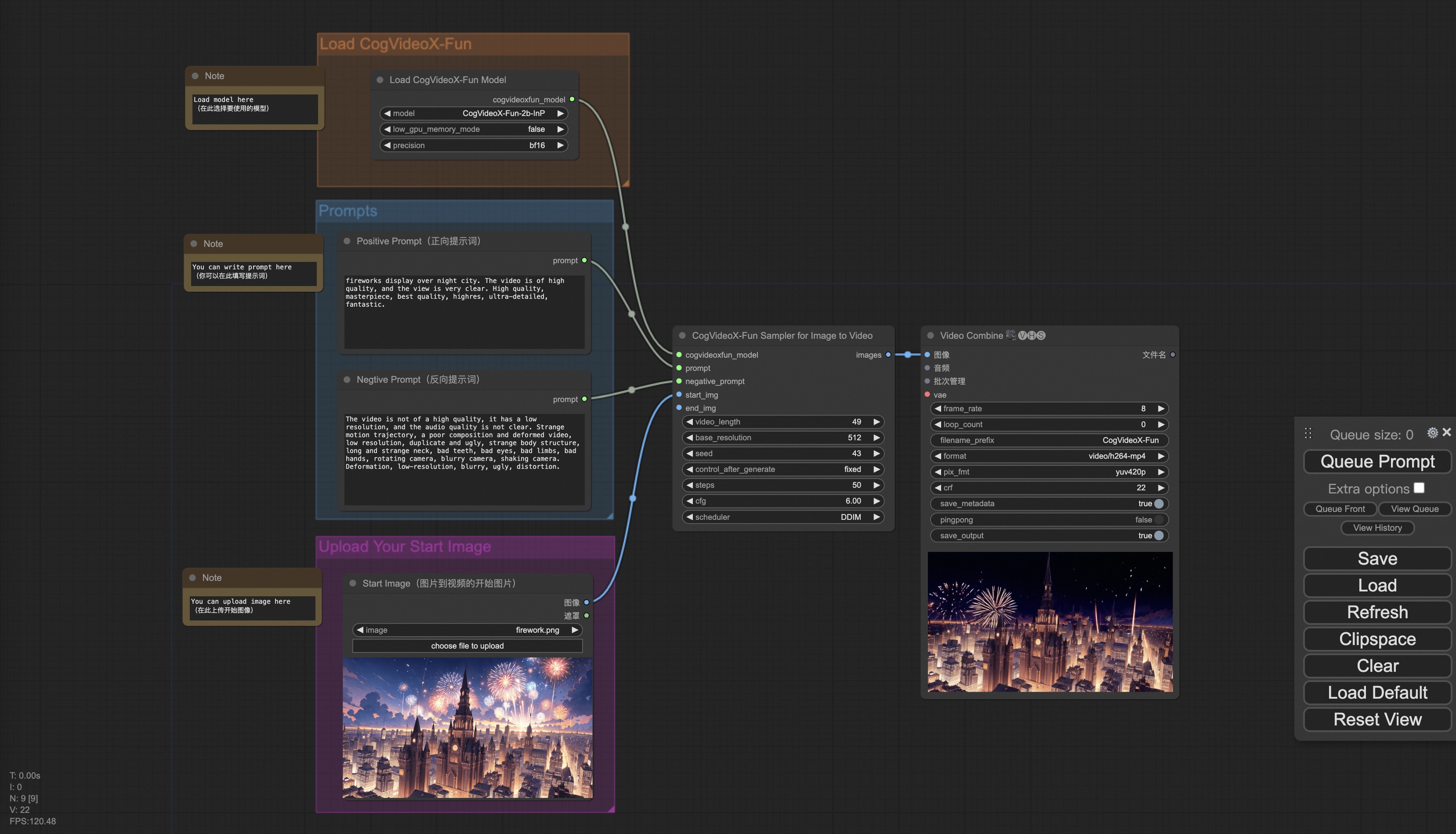

-

|

| 45 |

-

|

| 46 |

-

|

| 47 |

-

|

| 48 |

-

|

| 49 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 50 |

-

|

| 51 |

-

|

| 52 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 53 |

-

|

| 54 |

-

<td>

|

| 55 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 56 |

-

|

| 57 |

-

|

| 58 |

-

|

| 59 |

-

|

| 60 |

-

|

| 61 |

-

|

| 62 |

-

|

| 63 |

-

|

| 64 |

-

|

| 65 |

-

<td>

|

| 66 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 67 |

-

</td>

|

| 68 |

-

|

| 69 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 70 |

-

|

| 71 |

-

|

| 72 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 73 |

-

</td>

|

| 74 |

-

|

| 75 |

-

|

| 76 |

-

|

| 77 |

-

|

| 78 |

-

|

| 79 |

-

|

| 80 |

-

|

| 81 |

-

|

| 82 |

-

|

| 83 |

-

|

| 84 |

-

|

| 85 |

-

<td>

|

| 86 |

-

|

| 87 |

-

</td>

|

| 88 |

-

<td>

|

| 89 |

-

|

| 90 |

-

</td>

|

| 91 |

-

|

| 92 |

-

|

| 93 |

-

|

| 94 |

-

|

| 95 |

-

<td>

|

| 96 |

-

<

|

| 97 |

-

</td>

|

| 98 |

-

|

| 99 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 100 |

-

|

| 101 |

-

|

| 102 |

-

|

| 103 |

-

|

| 104 |

-

|

| 105 |

-

|

| 106 |

-

|

| 107 |

-

|

| 108 |

-

|

| 109 |

-

|

| 110 |

-

|

| 111 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 112 |

-

|

| 113 |

-

|

| 114 |

-

|

| 115 |

-

|

| 116 |

-

<

|

| 117 |

-

|

| 118 |

-

|

| 119 |

-

|

| 120 |

-

|

| 121 |

-

<td>

|

| 122 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 123 |

-

</td>

|

| 124 |

-

|

| 125 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 126 |

-

|

| 127 |

-

|

| 128 |

-

|

| 129 |

-

|

| 130 |

-

|

| 131 |

-

<td>

|

| 132 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 133 |

-

</td>

|

| 134 |

-

|

| 135 |

-

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/

|

| 136 |

-

|

| 137 |

-

|

| 138 |

-

|

| 139 |

-

|

| 140 |

-

|

| 141 |

-

|

| 142 |

-

|

| 143 |

-

|

| 144 |

-

|

| 145 |

-

|

| 146 |

-

|

| 147 |

-

|

| 148 |

-

|

| 149 |

-

|

| 150 |

-

|

| 151 |

-

|

| 152 |

-

|

| 153 |

-

|

| 154 |

-

|

| 155 |

-

|

| 156 |

-

|

| 157 |

-

|

| 158 |

-

|

| 159 |

-

|

| 160 |

-

#

|

| 161 |

-

docker

|

| 162 |

-

|

| 163 |

-

#

|

| 164 |

-

|

| 165 |

-

|

| 166 |

-

#

|

| 167 |

-

|

| 168 |

-

|

| 169 |

-

#

|

| 170 |

-

|

| 171 |

-

|

| 172 |

-

|

| 173 |

-

|

| 174 |

-

|

| 175 |

-

|

| 176 |

-

#

|

| 177 |

-

|

| 178 |

-

#

|

| 179 |

-

# https://

|

| 180 |

-

|

| 181 |

-

#

|

| 182 |

-

# https://

|

| 183 |

-

|

| 184 |

-

|

| 185 |

-

|

| 186 |

-

|

| 187 |

-

|

| 188 |

-

|

| 189 |

-

|

| 190 |

-

|

| 191 |

-

|

| 192 |

-

|

| 193 |

-

-

|

| 194 |

-

-

|

| 195 |

-

-

|

| 196 |

-

|

| 197 |

-

|

| 198 |

-

-

|

| 199 |

-

|

| 200 |

-

|

| 201 |

-

-

|

| 202 |

-

-

|

| 203 |

-

-

|

| 204 |

-

|

| 205 |

-

|

| 206 |

-

|

| 207 |

-

|

| 208 |

-

|

| 209 |

-

|

| 210 |

-

|

| 211 |

-

|

| 212 |

-

|

| 213 |

-

|

| 214 |

-

|

| 215 |

-

|

| 216 |

-

|

| 217 |

-

|

| 218 |

-

│

|

| 219 |

-

│

|

| 220 |

-

|

| 221 |

-

|

| 222 |

-

|

| 223 |

-

```

|

| 224 |

-

|

| 225 |

-

|

| 226 |

-

|

| 227 |

-

|

| 228 |

-

|

| 229 |

-

│

|

| 230 |

-

├── 📂

|

| 231 |

-

│

|

| 232 |

-

|

| 233 |

-

|

| 234 |

-

|

| 235 |

-

|

| 236 |

-

|

| 237 |

-

|

| 238 |

-

|

| 239 |

-

|

| 240 |

-

|

| 241 |

-

|

| 242 |

-

-

|

| 243 |

-

|

| 244 |

-

|

| 245 |

-

|

| 246 |

-

|

| 247 |

-

|

| 248 |

-

|

| 249 |

-

|

| 250 |

-

####

|

| 251 |

-

|

| 252 |

-

|

| 253 |

-

|

| 254 |

-

|

| 255 |

-

|

| 256 |

-

-

|

| 257 |

-

- 使用examples/cogvideox_fun/

|

| 258 |

-

-

|

| 259 |

-

|

| 260 |

-

|

| 261 |

-

-

|

| 262 |

-

-

|

| 263 |

-

|

| 264 |

-

|

| 265 |

-

-

|

| 266 |

-

-

|

| 267 |

-

|

| 268 |

-

-

|

| 269 |

-

|

| 270 |

-

|

| 271 |

-

|

| 272 |

-

|

| 273 |

-

|

| 274 |

-

|

| 275 |

-

-

|

| 276 |

-

|

| 277 |

-

|

| 278 |

-

|

| 279 |

-

-

|

| 280 |

-

|

| 281 |

-

|

| 282 |

-

-

|

| 283 |

-

-

|

| 284 |

-

-

|

| 285 |

-

-

|

| 286 |

-

-

|

| 287 |

-

|

| 288 |

-

|

| 289 |

-

|

| 290 |

-

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

license: apache-2.0

|

| 3 |

+

language:

|

| 4 |

+

- en

|

| 5 |

+

- zh

|

| 6 |

+

pipeline_tag: image-to-video

|

| 7 |

+

library_name: diffusers

|

| 8 |

+

tags:

|

| 9 |

+

- video

|

| 10 |

+

- video-generation

|

| 11 |

+

- wan2.2

|

| 12 |

+

base_model:

|

| 13 |

+

- Wan-AI/Wan2.2-I2V-A14B

|

| 14 |

+

---

|

| 15 |

+

|

| 16 |

+

# Wan-Fun

|

| 17 |

+

|

| 18 |

+

😊 Welcome!

|

| 19 |

+

|

| 20 |

+

[](https://huggingface.co/spaces/alibaba-pai/Wan2.1-Fun-1.3B-InP)

|

| 21 |

+

|

| 22 |

+

[](https://github.com/aigc-apps/VideoX-Fun)

|

| 23 |

+

|

| 24 |

+

[English](./README_en.md) | [简体中文](./README.md)

|

| 25 |

+

|

| 26 |

+

# 目录

|

| 27 |

+

- [目录](#目录)

|

| 28 |

+

- [模型地址](#模型地址)

|

| 29 |

+

- [视频作品](#视频作品)

|

| 30 |

+

- [快速启动](#快速启动)

|

| 31 |

+

- [如何使用](#如何使用)

|

| 32 |

+

- [参考文献](#参考文献)

|

| 33 |

+

- [许可证](#许可证)

|

| 34 |

+

|

| 35 |

+

# 模型地址

|

| 36 |

+

|

| 37 |

+

| 名称 | 存储空间 | Hugging Face | Model Scope | 描述 |

|

| 38 |

+

|--|--|--|--|--|

|

| 39 |

+

| Wan2.2-Fun-A14B-InP | 47.0 GB | [🤗Link](https://huggingface.co/alibaba-pai/Wan2.2-Fun-A14B-InP) | [😄Link](https://modelscope.cn/models/PAI/Wan2.2-Fun-A14B-InP) | Wan2.2-Fun-14B文图生视频权重,以多分辨率训练,支持首尾图预测。 |

|

| 40 |

+

| Wan2.2-Fun-A14B-Control | 47.0 GB | [🤗Link](https://huggingface.co/alibaba-pai/Wan2.2-Fun-A14B-Control) | [😄Link](https://modelscope.cn/models/PAI/Wan2.2-Fun-A14B-Control)| Wan2.2-Fun-14B视频控制权重,支持不同的控制条件,如Canny、Depth、Pose、MLSD等,同时支持使用轨迹控制。支持多分辨率(512,768,1024)的视频预测,支持多分辨率(512,768,1024)的视频预测,以81帧、每秒16帧进行训练,支持多语言预测 |

|

| 41 |

+

|

| 42 |

+

# 视频作品

|

| 43 |

+

|

| 44 |

+

### Wan2.2-Fun-A14B-InP

|

| 45 |

+

|

| 46 |

+

<table border="0" style="width: 100%; text-align: left; margin-top: 20px;">

|

| 47 |

+

<tr>

|

| 48 |

+

<td>

|

| 49 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_1.mp4" width="100%" controls autoplay loop></video>

|

| 50 |

+

</td>

|

| 51 |

+

<td>

|

| 52 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_2.mp4" width="100%" controls autoplay loop></video>

|

| 53 |

+

</td>

|

| 54 |

+

<td>

|

| 55 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_3.mp4" width="100%" controls autoplay loop></video>

|

| 56 |

+

</td>

|

| 57 |

+

<td>

|

| 58 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_4.mp4" width="100%" controls autoplay loop></video>

|

| 59 |

+

</td>

|

| 60 |

+

</tr>

|

| 61 |

+

</table>

|

| 62 |

+

|

| 63 |

+

<table border="0" style="width: 100%; text-align: left; margin-top: 20px;">

|

| 64 |

+

<tr>

|

| 65 |

+

<td>

|

| 66 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_5.mp4" width="100%" controls autoplay loop></video>

|

| 67 |

+

</td>

|

| 68 |

+

<td>

|

| 69 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_6.mp4" width="100%" controls autoplay loop></video>

|

| 70 |

+

</td>

|

| 71 |

+

<td>

|

| 72 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_7.mp4" width="100%" controls autoplay loop></video>

|

| 73 |

+

</td>

|

| 74 |

+

<td>

|

| 75 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/inp_8.mp4" width="100%" controls autoplay loop></video>

|

| 76 |

+

</td>

|

| 77 |

+

</tr>

|

| 78 |

+

</table>

|

| 79 |

+

|

| 80 |

+

### Wan2.2-Fun-A14B-Control

|

| 81 |

+

|

| 82 |

+

Generic Control Video + Reference Image:

|

| 83 |

+

<table border="0" style="width: 100%; text-align: left; margin-top: 20px;">

|

| 84 |

+

<tr>

|

| 85 |

+

<td>

|

| 86 |

+

Reference Image

|

| 87 |

+

</td>

|

| 88 |

+

<td>

|

| 89 |

+

Control Video

|

| 90 |

+

</td>

|

| 91 |

+

<td>

|

| 92 |

+

Wan2.2-Fun-14B-Control

|

| 93 |

+

</td>

|

| 94 |

+

<tr>

|

| 95 |

+

<td>

|

| 96 |

+

<image src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/8.png" width="100%" controls autoplay loop></image>

|

| 97 |

+

</td>

|

| 98 |

+

<td>

|

| 99 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/pose.mp4" width="100%" controls autoplay loop></video>

|

| 100 |

+

</td>

|

| 101 |

+

<td>

|

| 102 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/14b_ref.mp4" width="100%" controls autoplay loop></video>

|

| 103 |

+

</td>

|

| 104 |

+

<tr>

|

| 105 |

+

</table>

|

| 106 |

+

|

| 107 |

+

Generic Control Video (Canny, Pose, Depth, etc.) and Trajectory Control:

|

| 108 |

+

<table border="0" style="width: 100%; text-align: left; margin-top: 20px;">

|

| 109 |

+

<tr>

|

| 110 |

+

<td>

|

| 111 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/guiji.mp4" width="100%" controls autoplay loop></video>

|

| 112 |

+

</td>

|

| 113 |

+

<td>

|

| 114 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/guiji_out.mp4" width="100%" controls autoplay loop></video>

|

| 115 |

+

</td>

|

| 116 |

+

<tr>

|

| 117 |

+

</table>

|

| 118 |

+

|

| 119 |

+

<table border="0" style="width: 100%; text-align: left; margin-top: 20px;">

|

| 120 |

+

<tr>

|

| 121 |

+

<td>

|

| 122 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/pose.mp4" width="100%" controls autoplay loop></video>

|

| 123 |

+

</td>

|

| 124 |

+

<td>

|

| 125 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/canny.mp4" width="100%" controls autoplay loop></video>

|

| 126 |

+

</td>

|

| 127 |

+

<td>

|

| 128 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/depth.mp4" width="100%" controls autoplay loop></video>

|

| 129 |

+

</td>

|

| 130 |

+

<tr>

|

| 131 |

+

<td>

|

| 132 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/pose_out.mp4" width="100%" controls autoplay loop></video>

|

| 133 |

+

</td>

|

| 134 |

+

<td>

|

| 135 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/canny_out.mp4" width="100%" controls autoplay loop></video>

|

| 136 |

+

</td>

|

| 137 |

+

<td>

|

| 138 |

+

<video src="https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/wan_fun/asset_Wan2_2/v1.0/depth_out.mp4" width="100%" controls autoplay loop></video>

|

| 139 |

+

</td>

|

| 140 |

+

</tr>

|

| 141 |

+

</table>

|

| 142 |

+

|

| 143 |

+

# 快速启动

|

| 144 |

+

### 1. 云使用: AliyunDSW/Docker

|

| 145 |

+

#### a. 通过阿里云 DSW

|

| 146 |

+

DSW 有免费 GPU 时间,用户可申请一次,申请后3个月内有效。

|

| 147 |

+

|

| 148 |

+

阿里云在[Freetier](https://free.aliyun.com/?product=9602825&crowd=enterprise&spm=5176.28055625.J_5831864660.1.e939154aRgha4e&scm=20140722.M_9974135.P_110.MO_1806-ID_9974135-MID_9974135-CID_30683-ST_8512-V_1)提供免费GPU时间,获取并在阿里云PAI-DSW中使用,5分钟内即可启动CogVideoX-Fun。

|

| 149 |

+

|

| 150 |

+

[](https://gallery.pai-ml.com/#/preview/deepLearning/cv/cogvideox_fun)

|

| 151 |

+

|

| 152 |

+

#### b. 通过ComfyUI

|

| 153 |

+

我们的ComfyUI界面如下,具体查看[ComfyUI README](comfyui/README.md)。

|

| 154 |

+

|

| 155 |

+

|

| 156 |

+

#### c. 通过docker

|

| 157 |

+

使用docker的情况下,请保证机器中已经正确安装显卡驱动与CUDA环境,然后以此执行以下命令:

|

| 158 |

+

|

| 159 |

+

```

|

| 160 |

+

# pull image

|

| 161 |

+

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

|

| 162 |

+

|

| 163 |

+

# enter image

|

| 164 |

+

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

|

| 165 |

+

|

| 166 |

+

# clone code

|

| 167 |

+

git clone https://github.com/aigc-apps/VideoX-Fun.git

|

| 168 |

+

|

| 169 |

+

# enter VideoX-Fun's dir

|

| 170 |

+

cd VideoX-Fun

|

| 171 |

+

|

| 172 |

+

# download weights

|

| 173 |

+

mkdir models/Diffusion_Transformer

|

| 174 |

+

mkdir models/Personalized_Model

|

| 175 |

+

|

| 176 |

+

# Please use the hugginface link or modelscope link to download the model.

|

| 177 |

+

# CogVideoX-Fun

|

| 178 |

+

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

|

| 179 |

+

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

|

| 180 |

+

|

| 181 |

+

# Wan

|

| 182 |

+

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-V1.1-14B-InP

|

| 183 |

+

# https://modelscope.cn/models/PAI/Wan2.1-Fun-V1.1-14B-InP

|

| 184 |

+

# https://huggingface.co/alibaba-pai/Wan2.2-Fun-A14B-InP

|

| 185 |

+

# https://modelscope.cn/models/PAI/Wan2.2-Fun-A14B-InP

|

| 186 |

+

```

|

| 187 |

+

|

| 188 |

+

### 2. 本地安装: 环境检查/下载/安装

|

| 189 |

+

#### a. 环境检查

|

| 190 |

+

我们已验证该库可在以下环境中执行:

|

| 191 |

+

|

| 192 |

+

Windows 的详细信息:

|

| 193 |

+

- 操作系统 Windows 10

|

| 194 |

+

- python: python3.10 & python3.11

|

| 195 |

+

- pytorch: torch2.2.0

|

| 196 |

+

- CUDA: 11.8 & 12.1

|

| 197 |

+

- CUDNN: 8+

|

| 198 |

+

- GPU: Nvidia-3060 12G & Nvidia-3090 24G

|

| 199 |

+

|

| 200 |

+

Linux 的详细信息:

|

| 201 |

+

- 操作系统 Ubuntu 20.04, CentOS

|

| 202 |

+

- python: python3.10 & python3.11

|

| 203 |

+

- pytorch: torch2.2.0

|

| 204 |

+

- CUDA: 11.8 & 12.1

|

| 205 |

+

- CUDNN: 8+

|

| 206 |

+

- GPU:Nvidia-V100 16G & Nvidia-A10 24G & Nvidia-A100 40G & Nvidia-A100 80G

|

| 207 |

+

|

| 208 |

+

我们需要大约 60GB 的可用磁盘空间,请检查!

|

| 209 |

+

|

| 210 |

+

#### b. 权重放置

|

| 211 |

+

我们最好将[权重](#model-zoo)按照指定路径进行放置:

|

| 212 |

+

|

| 213 |

+

**通过comfyui**:

|

| 214 |

+

将模型放入Comfyui的权重文件夹`ComfyUI/models/Fun_Models/`:

|

| 215 |

+

```

|

| 216 |

+

📦 ComfyUI/

|

| 217 |

+

├── 📂 models/

|

| 218 |

+

│ └── 📂 Fun_Models/

|

| 219 |

+

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

|

| 220 |

+

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

|

| 221 |

+

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

|

| 222 |

+

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

|

| 223 |

+

```

|

| 224 |

+

|

| 225 |

+

**运行自身的python文件或ui界面**:

|

| 226 |

+

```

|

| 227 |

+

📦 models/

|

| 228 |

+

├── 📂 Diffusion_Transformer/

|

| 229 |

+

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

|

| 230 |

+

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

|

| 231 |

+

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

|

| 232 |

+

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

|

| 233 |

+

├── 📂 Personalized_Model/

|

| 234 |

+

│ └── your trained trainformer model / your trained lora model (for UI load)

|

| 235 |

+

```

|

| 236 |

+

|

| 237 |

+

# 如何使用

|

| 238 |

+

|

| 239 |

+

<h3 id="video-gen">1. 生成 </h3>

|

| 240 |

+

|

| 241 |

+

#### a、显存节省方案

|

| 242 |

+

由于Wan2.2的参数非常大,我们需要考虑显存节省方案,以节省显存适应消费级显卡。我们给每个预测文件都提供了GPU_memory_mode,可以在model_cpu_offload,model_cpu_offload_and_qfloat8,sequential_cpu_offload中进行选择。该方案同样适用于CogVideoX-Fun的生成。

|

| 243 |

+

|

| 244 |

+

- model_cpu_offload代表整个模型在使用后会进入cpu,可以节省部分显存。

|

| 245 |

+

- model_cpu_offload_and_qfloat8代表整个模型在使用后会进入cpu,并且对transformer模型进行了float8的量化,可以节省更多的显存。

|

| 246 |

+

- sequential_cpu_offload代表模型的每一层在使用后会进入cpu,速度较慢,节省大量显存。

|

| 247 |

+

|

| 248 |

+

qfloat8会部分降低模型的性能,但可以节省更多的显存。如果显存足够,推荐使用model_cpu_offload。

|

| 249 |

+

|

| 250 |

+

#### b、通过comfyui

|

| 251 |

+

具体查看[ComfyUI README](https://github.com/aigc-apps/VideoX-Fun/tree/main/comfyui)。

|

| 252 |

+

|

| 253 |

+

#### c、运行python文件

|

| 254 |

+

- 步骤1:下载对应[权重](#model-zoo)放入models文件夹。

|

| 255 |

+

- 步骤2:根据不同的权重与预测目标使用不同的文件进行预测。当前该库支持CogVideoX-Fun、Wan2.1、Wan2.1-Fun、Wan2.2,在examples文件夹下用文件夹名以区分,不同模型支持的功能不同,请视具体情况予以区分。以CogVideoX-Fun为例。

|

| 256 |

+

- 文生视频:

|

| 257 |

+

- 使用examples/cogvideox_fun/predict_t2v.py文件中修改prompt、neg_prompt、guidance_scale和seed。

|

| 258 |

+

- 而后运行examples/cogvideox_fun/predict_t2v.py文件,等待生成结果,结果保存在samples/cogvideox-fun-videos文件夹中。

|

| 259 |

+

- 图生视频:

|

| 260 |

+

- 使用examples/cogvideox_fun/predict_i2v.py文件中修改validation_image_start、validation_image_end、prompt、neg_prompt、guidance_scale和seed。

|

| 261 |

+

- validation_image_start是视频的开始图片,validation_image_end是视频的结尾图片。

|

| 262 |

+

- 而后运行examples/cogvideox_fun/predict_i2v.py文件,等待生成结果,结果保存在samples/cogvideox-fun-videos_i2v文件夹中。

|

| 263 |

+

- 视频生视频:

|

| 264 |

+

- 使用examples/cogvideox_fun/predict_v2v.py文件中修改validation_video、validation_image_end、prompt、neg_prompt、guidance_scale和seed。

|

| 265 |

+

- validation_video是视频生视频的参考视频。您可以使用以下视频运行演示:[演示视频](https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/cogvideox_fun/asset/v1/play_guitar.mp4)

|

| 266 |

+

- 而后运行examples/cogvideox_fun/predict_v2v.py文件,等待生成结果,结果保存在samples/cogvideox-fun-videos_v2v文件夹中。

|

| 267 |

+

- 普通控制生视频(Canny、Pose、Depth等):

|

| 268 |

+

- 使用examples/cogvideox_fun/predict_v2v_control.py文件中修改control_video、validation_image_end、prompt、neg_prompt、guidance_scale和seed。

|

| 269 |

+

- control_video是控制生视频的控制视频,是使用Canny、Pose、Depth等算子提取后的视频。您可以使用以下视频运行演示:[演示视频](https://pai-aigc-photog.oss-cn-hangzhou.aliyuncs.com/cogvideox_fun/asset/v1.1/pose.mp4)

|

| 270 |

+

- 而后运行examples/cogvideox_fun/predict_v2v_control.py文件,等待生成结果,结果保存在samples/cogvideox-fun-videos_v2v_control文件夹中。

|

| 271 |

+

- 步骤3:如果想结合自己训练的其他backbone与Lora,则看情况修改examples/{model_name}/predict_t2v.py中的examples/{model_name}/predict_i2v.py和lora_path。

|

| 272 |

+

|

| 273 |

+

#### d、通过ui界面

|

| 274 |

+

|

| 275 |

+

webui支持文生视频、图生视频、视频生视频和普通控制生视频(Canny、Pose、Depth等)。在examples文件夹下用文件夹名以区分,不同模型支持的功能不同,请视具体情况予以区分。以CogVideoX-Fun为例。

|

| 276 |

+

|

| 277 |

+

- 步骤1:下载对应[权重](#model-zoo)放入models文件夹。

|

| 278 |

+

- 步骤2:运行examples/cogvideox_fun/app.py文件,进入gradio页面。

|

| 279 |

+

- 步骤3:根据页面选择生成模型,填入prompt、neg_prompt、guidance_scale和seed等,点击生成,等待生成结果,结果保存在sample文件夹中。

|

| 280 |

+

|

| 281 |

+

# 参考文献

|

| 282 |

+

- CogVideo: https://github.com/THUDM/CogVideo/

|

| 283 |

+

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

|

| 284 |

+

- Wan2.1: https://github.com/Wan-Video/Wan2.1/

|

| 285 |

+

- Wan2.1: https://github.com/Wan-Video/Wan2.2/

|

| 286 |

+

- ComfyUI-KJNodes: https://github.com/kijai/ComfyUI-KJNodes

|

| 287 |

+

- ComfyUI-EasyAnimateWrapper: https://github.com/kijai/ComfyUI-EasyAnimateWrapper

|

| 288 |

+

- ComfyUI-CameraCtrl-Wrapper: https://github.com/chaojie/ComfyUI-CameraCtrl-Wrapper

|

| 289 |

+

- CameraCtrl: https://github.com/hehao13/CameraCtrl

|

| 290 |

+

|

| 291 |

+

# 许可证

|

| 292 |

+

本项目采用 [Apache License (Version 2.0)](https://github.com/modelscope/modelscope/blob/master/LICENSE).

|